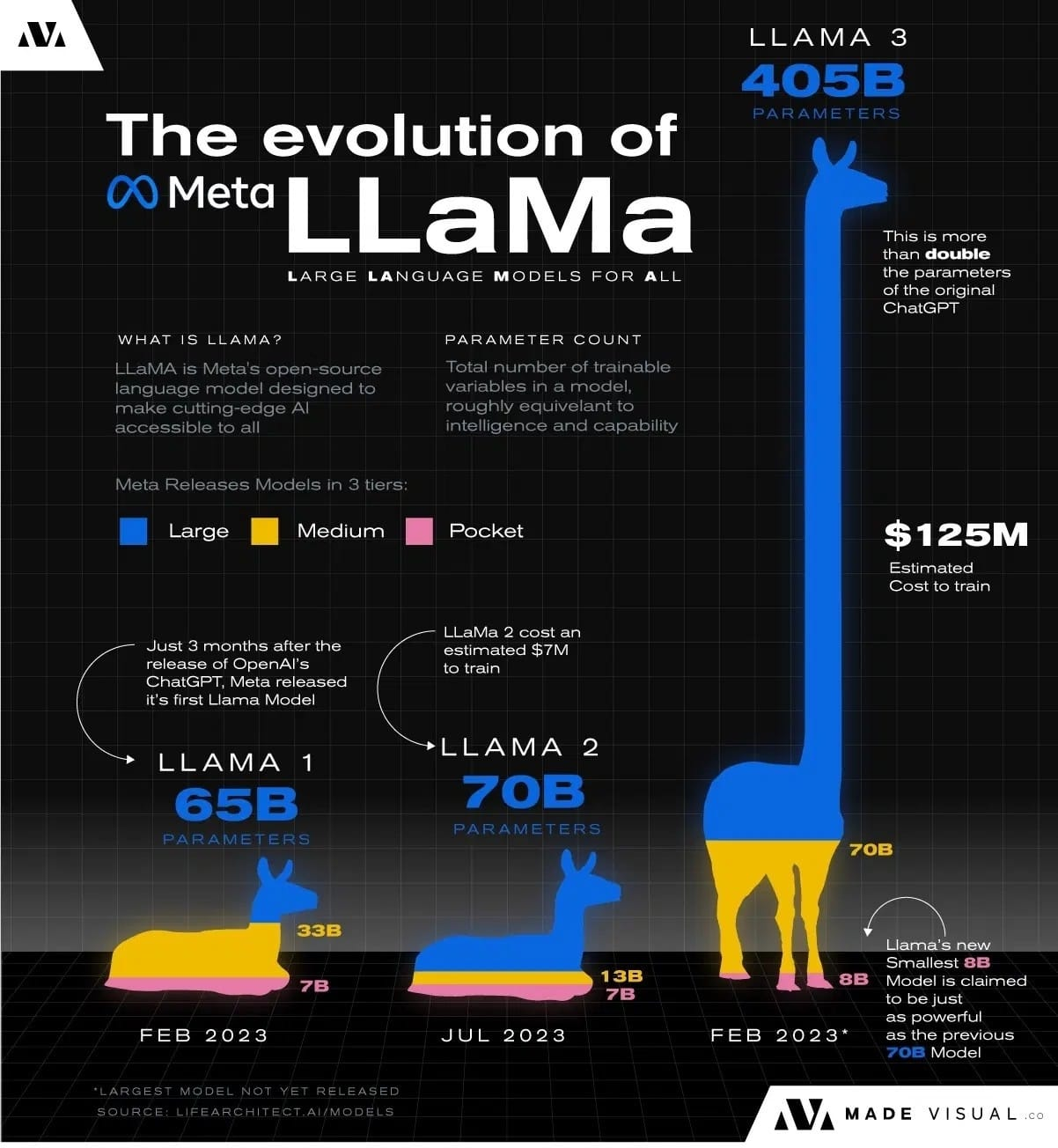

iPhone에서 Llama3 8B 모델을 구동시키는데 성공했다는 뉴스가 나오자마자 인터넷 곳곳에서 따라하기에 성공사례가 연달아 나오고 있습니다.

정리하자면

애플 실리콘은 애플이 독자적으로 만든 반도체입니다. 그래서 인텔, AMD의 프로세서와 Nvidia GPU용으로 만들어진 모델이 그냥 작동하지 않습니다. Llama3도 마찬가지입니다. 돌아간다고 하더라도 효율이 문제인데 그래서 애플은 애플 실리콘에서 작동하는 자체 고속행렬연산 프레임워크인 MLX라는 것을 만들었습니다.

Llama3를 애플의 아이폰, 아이패드에서 돌리려면 MLX에서 돌도록 해야 제대로 되는데 그걸 매우 쉽게 했다는 것입니다.

아이폰 다음 모델에는 거의 온디비이스 AI 탑재될 것이 분명합니다.

온디바이스AI는 디바이스내에서 외부 통신없이 자체 능력만으로도 AI 프로세싱을 처리할 수 있는 것을 말합니다.

세상이 바뀌는 순간이 매우 빠르게 오고 있다는 느낌이 듭니다.

다음은 Llama3 8B를 iPhone 15 Pro Max에 설치하는 방법입니다. 편의상 영문 그대로 올립니다.

UPDATE: Successfully ran Llama3 8B Instruct on iPhone 15 Pro Max

Steps:

1. Install LLM Farm

2. Download Llama3 8B Instruct GGUF from Huggingface

3. Import & Run the model in LLM Farm

LLM Farm: https://llmfarm.site

Model File: https://huggingface.co/FaradayDotDev/llama-3-8b-Instruct-GGUF… Detailed steps coming soon!